[Daily] 2022년 우수학술도서 선정

[Daily] 2022년 우수학술도서 선정

아마 블로그를 자주 들어온 사람이라면 알고있겠지만, 개인적으로 강화학습을 공부하면서 책 한권을 번역했었다. [Me] 그로킹 심층 강화학습 몇 달전에 번역하고 있는 책에 대한 짧은 글을 썼었는데, 며칠 전에 하판되었다는 연락을 받고, 이번주 일요일에 출간한다는 이야기를 전달받았다. 실제로 출판사 웹사이트에도 등록되어 있는 talkingaboutme.tistory.com 작년 10월에 출간된 책이고, 나름 1년동안 준비하면서 시행착오도 겪었지만, 번역을 하면서 나름 결과물을 얻었던 것 같다. 물론 그 결과물이 책의 매출로 직결되었는지는 잘 모르겠지만, 그래도 개인적으로는 조금더 심층강화학습이라는 것을 접하면서 더 깊은 영역을 파고들 수 있게 해주지 않았나 싶다. 덕분에 회사에서도 관련된 주제로 계속 연구할 ..

[Book] Learning algorithm

[Book] Learning algorithm

(해당 포스트에서 소개하고 있는 "Learning Algorithm: 똑똑한 코드 작성을 위한 실전 알고리즘" 책은 한빛 미디어로부터 제공받았음을 알려드립니다.) 똑똑한 코드 작성을 위한 실전 알고리즘 파이썬 예제를 실행해보면서 컴퓨터 과학의 핵심 알고리즘과 문제 해결법을 익히는 책 hanbit.co.kr 아마 유명한 IT 업계로 취업하려는 사람들은 알겠지만 시중에는 정말 다양한 알고리즘 책들이 존재한다. 다양한 책들마다 나름대로의 내용을 풀어가는 방향이 다 다르다. 예를 들어서 어떤 책은 문제은행 식으로 많은 케이스들을 제공하고 이에 대한 해설을 제공하는 형태가 있다. 또 다른 책은 정렬이나 탐색, 그래프와 같이 문제를 푸는데 있어서 필요한 기본 지식들에 대해서 하나씩 다루는 형태로 되어있는 경우도 있..

[Book] 구글 엔지니어는 이렇게 일한다

[Book] 구글 엔지니어는 이렇게 일한다

(해당 포스트에서 소개하고 있는 "구글 엔지니어는 이렇게 일한다" 책은 한빛 미디어로부터 제공받았음을 알려드립니다.) 구글 엔지니어는 이렇게 일한다 지난 20년간 구글 소프트웨어 엔지니어가 구글에서 직접 경험한 내용을 바탕으로 코드의 가치를 가장 잘 유지하는 방법, 소프트웨어를 효율적으로 관리하는 프로세스 도입 방법, 구글의 문화를 hanbit.co.kr 아마 IT업계에서 일하는 사람들이라면 각자 속한 팀내에서 활용되는 규칙이나 철학같은 것이 있을 것이다. 나름의 규칙을 가지고 에자일 프로세스를 따르기도 하고, 코드 리뷰를 통해 오류를 찾는 과정을 거치며, 정적분석을 통해 소프트웨어의 품질을 유지하려고 노력할 것이다. 내가 속한 팀도 그렇게 엄격하지는 않더라도 나름의 규칙을 통해서 이런 개발 프로세스를 ..

[RL][Review] Hyperparameter Selection for Offline Reinforcement Learning

[RL][Review] Hyperparameter Selection for Offline Reinforcement Learning

(본문의 의도를 가져오되, 개인적인 의견이 담길 수도 있습니다.) Hyperparameter Selection for Offline Reinforcement Learning - Le Paine et al, NeurIPS 2020 Offline RL workshop (논문, 영상) 요약 Offline RL은 실제 환경에 RL 기법들을 적용하기 좋은 방법론이긴 하지만 환경상에서 어떤 policy가 좋은 policy인지 각 hyperparameter에 따라서 평가하는 과정으로 인해 offline 가정이 깨지게 된다. 이렇게 online 상에서 수행하는 과정으로 인해 offline RL을 통해 추구하는 목표가 상대적으로 약화된다. 그래서 이 논문에서는 offline hyperparameter selection,..

[RL][Review] Offline Reinforcement Learning From Algorithms to Practical Challenges

[RL][Review] Offline Reinforcement Learning From Algorithms to Practical Challenges

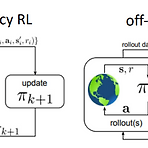

(본문의 의도를 가져오되, 개인적인 의견이 담길 수도 있습니다.) Offline Reinforcement Learning from Algorithms to Practical Challenges - Kumar et al, NeurIPS 2020 Tutorial (사이트, 실습코드) 원래 거진 3시간짜리 tutorial이기 때문에 정리하는데 시간이 걸릴듯 하다. 그래도 전반적인 Offline RL의 문제와 이론에 대해서 잘 설명되어 있어서 차근차근 설명해보고자 한다. 기본적인 RL 내용도 포함되어 있어, Offline RL 부분만 뽑아서 정리한다. Can we develop data-driven RL methods? 보통 강화학습이라고 하면 다음과 같은 환경을 가정하고 진행한다. 일반적으로는 어떤 환경이 주..

[Book] 파이썬을 활용한 금융 분석

[Book] 파이썬을 활용한 금융 분석

(해당 포스트에서 소개하고 있는 "파이썬을 활용한 금융 분석" 책은 한빛 미디어로부터 제공받았음을 알려드립니다.) 파이썬을 활용한 금융 분석(2판) 금융 분야 종사자, 관련 개발자들이 파이썬을 시작하고 이를 활용하여 중용한 금융 분석 업무를 할 수 있도록 도와주는 최적의 실무 가이드 북입니다. hanbit.co.kr 아마 주식을 하고 있다면 솔깃한 내용 중 하나는 과연 인공지능으로 주식을 자동으로 거래하게 해서 돈을 벌 수 있을까 일 것이다. 그래서 시중에도 증권API를 파이썬으로 다루는 방법에 대한 내용을 소개한 책들이 다수 소개되어 있다. 물론 수많은 접근 방식이 있겠지만, 모든 접근 방식보다도 선행되어야 할 것은 데이터 분석이 아닐까 생각된다. (과거를 포함하여) 현재 쌓여 있는 특정 데이터속에서 ..

[RL][Review] Offline RL without Off-Policy Evaluation (onestep-rl)

[RL][Review] Offline RL without Off-Policy Evaluation (onestep-rl)

(논문의 의도를 가져오되, 개인적인 의견이 담길 수도 있습니다.) Offline RL without Off-Policy Evaluation - Brandfonbrener et al, NeurIPS 2021 (논문, 코드) 요약 이전에 수행된 대부분의 Offline RL에서는 off-policy evaluation과 관련된 반복적인 Actor-critic 기법을 활용했다. 이 논문에서는 behavior policy의 on-policy Q estimate를 사용해서 제한된/정규화된 policy improvement를 단순히 한번만 수행해도 잘 동작하는 것을 확인했다.이 one-step baseline이 이전에 발표되었던 논문에 비하면 눈에 띌만큼 간단하면서도 hyperparameter에 대해서 robust한..

[RL][Review] Stabilizing Off-Policy Q-Learning via Bootstrapping Error Reduction (BEAR)

[RL][Review] Stabilizing Off-Policy Q-Learning via Bootstrapping Error Reduction (BEAR)

(논문의 의도를 가져오되, 개인적인 의견이 담길 수도 있습니다.) Stabilizing Off-Policy Q-Learning via Bootstrapping Error Reduction - Kumar et al, NeurIPS 2019 (논문, 코드) 요약 Off-policy RL은 샘플링 관점에서 효율적인 학습을 위해서 다른 policy (behavior policy)로부터 수집한 데이터로부터 경험을 배우는데 초점을 맞추지만, Q-learning이나 Actor-Critic 기반의 off-policy Approximate dynamic programming 기법은 학습시 사용된 데이터와 실제 데이터간의 분포가 다른 문제로 인해서 on-policy data를 추가로 활용하지 않고서는 성능을 개선하기가 어..

[RL][Review] Off-Policy Deep Reinforcement Learning without Exploration (BCQ)

[RL][Review] Off-Policy Deep Reinforcement Learning without Exploration (BCQ)

(논문의 의도를 가져오되, 개인적인 의견이 담길 수도 있습니다.) Off-Policy Deep Reinforcement Learning without Exploration - Fujimoto et al, ICML 2019 (논문, 코드) 요약 이 논문에서는 이미 모아져있는 고정된 dataset 상에서 강화학습 에이전트를 학습할 수 있는 알고리즘을 소개한다. 보통 강화학습은 exploration을 통해서 insight를 얻어내고, 이에 대한 경험으로 성능을 추출하는 형태로 되어 있지만, 고정된 dataset으로부터 학습하게 되면 exploration을 할 수 없기 때문에 성능을 얻어낼 요소가 부족하다. 이런 종류의 알고리즘을 Offline RL 혹은 Batch RL이라고 표현하고, 사실 이 알고리즘은 be..

- Total

- Today

- Yesterday

- bias

- Windows Phone 7

- Kinect

- 파이썬

- Policy Gradient

- Kinect SDK

- Distribution

- windows 8

- Kinect for windows

- End-To-End

- 딥러닝

- 강화학습

- 한빛미디어

- SketchFlow

- Expression Blend 4

- TensorFlow Lite

- Pipeline

- Gan

- 인공지능

- dynamic programming

- RL

- ColorStream

- arduino

- Off-policy

- Variance

- DepthStream

- Offline RL

- reward

- PowerPoint

- processing

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |