[RL] Q-learning: Off-policy TD Control

[RL] Q-learning: Off-policy TD Control

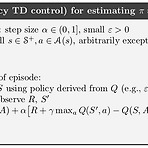

(해당 포스트는 Coursera의 Sample-based Learning Methods의 강의 요약본입니다) 사실 Q-learning에 대해서는 옛날에 한 포스트를 통해서 다뤘었는데, 다시 정리를 해보고자 한다. 일단 알고리즘은 아래와 같다. 이전 포스트에서 다뤘던 SARSA와 거의 비슷한데, 한가지 다른 부분이 바로 Value function을 update하는 부분이다. 다시 한번 SARSA의 update 부분을 살펴보자. Q(St,At)←Q(St,At)+α(Rt+1+γQ(St+1,At+1)−Q(St,At)) 그런데 위의 식은 사실 Dynamic Programm..

Study/AI

2019. 9. 11. 16:54

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

TAG

- processing

- Kinect

- End-To-End

- arduino

- PowerPoint

- Kinect SDK

- Variance

- windows 8

- DepthStream

- Offline RL

- Kinect for windows

- SketchFlow

- reward

- Gan

- Expression Blend 4

- bias

- ColorStream

- Pipeline

- Off-policy

- Policy Gradient

- 강화학습

- Distribution

- RL

- 한빛미디어

- Windows Phone 7

- dynamic programming

- 딥러닝

- TensorFlow Lite

- 파이썬

- 인공지능

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

글 보관함