[RL] Dyna as a formalism for planning

[RL] Dyna as a formalism for planning

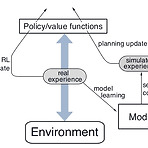

(해당 포스트는 Coursera의 Sample-based Learning Methods의 강의 요약본입니다) 이전 포스트를 통해서 강화학습 상에서의 Model의 정의에 대해서 소개하고, Model을 통해서 생성한 simulated experience를 바탕으로 model을 update하는 Planning에 대해서 다뤘다. 사실 이런 planning과정과 별개로 실제 environment로부터 얻은 experience를 바탕으로 update하는 것을 Direct RL이라고 표현한다. 이번 포스트에서 소개할 Dyna algorithm (sutton)은 앞에서 소개된 Planning과 Direct RL이 결합된 형태로 되어 있다. 우선 기존의 Q-learning과 마찬가지로 실제 environment로부터 e..

Study/AI

2019. 9. 30. 18:21

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

TAG

- Pipeline

- reward

- Expression Blend 4

- 딥러닝

- PowerPoint

- TensorFlow Lite

- ai

- RL

- Off-policy

- 파이썬

- Windows Phone 7

- Offline RL

- Kinect SDK

- Gan

- Variance

- 한빛미디어

- arduino

- ColorStream

- Kinect for windows

- Kinect

- SketchFlow

- Policy Gradient

- windows 8

- Distribution

- 강화학습

- processing

- bias

- dynamic programming

- End-To-End

- DepthStream

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 | 31 |

글 보관함