[RL] Catching Signals That Sound in the Dark

[RL] Catching Signals That Sound in the Dark

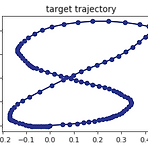

강화학습의 본질은 시간대별로 dynamic하게 변하는 시스템의 미래를 형상화하는데 이전의 데이터를 활용하는 것이다. 강화학습의 가장 흔한 예가 episodic model을 따르는 것인데, 이는 특정 단위의 action이 정의되고, 시스템 상에서 테스트되었고, 특정 단위의 reward와 state가 관찰되고, 이런 이전의 action과 reward, state 정보들이 결합되어 행동을 결정하는 policy를 향상시키는데 사용되는 것이다. 시스템과 상호반응하는 것 자체가 매우 고급지고 복잡한 모델이기도 하고, 일반적인 확률적인 최적화 방식에 비하면 조금 더 복잡하다고 고려되기도 한다. 미래의 성능을 향상시키기 위해서 수집된 데이터 모두를 잘 활용하는 방법이 있을까? policy gradient나 random..

Study/AI

2019. 3. 28. 11:24

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

TAG

- ColorStream

- Policy Gradient

- dynamic programming

- bias

- Kinect for windows

- DepthStream

- PowerPoint

- Distribution

- Pipeline

- 딥러닝

- Gan

- Expression Blend 4

- Windows Phone 7

- Variance

- ai

- reward

- RL

- windows 8

- SketchFlow

- TensorFlow Lite

- Kinect

- Off-policy

- processing

- 한빛미디어

- 파이썬

- Offline RL

- End-To-End

- arduino

- 강화학습

- Kinect SDK

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 | 31 |

글 보관함